Irgendwann in der Primarschule, typischerweise ab der vierten Klasse, kommt man zum ersten Mal mit Sätzchen-Rechnungen in Kontakt. Für die einen ist das ein Grund zur Freude (endlich macht Rechnen auch mal praktisch Sinn), für die anderen eher ein erster Mathe-Frust (um was geht es denn da). Aussehen können die beispielsweise wie folgt:

Oliver pflückt am Freitag 44 Kiwis. Am Samstag pflückt er dann 58 Kiwis. Am Sonntag pflückt er doppelt so viele Kiwis wie am Freitag. Wie viele Kiwis hat Oliver?

Das Ergebnis schaffen vermutlich auch die, welche in der Primarschule mit dieser Art von Aufgaben haderten:

44 (vom Freitag) + 58 (vom Samstag) + 2 * 44 (vom Sonntag) -> 190 Kiwi

Wer sich sicher sein will, kann natürlich auch den Chatbot seines Vertrauens befragen.

Um die Gesamtzahl der Kiwis zu ermitteln, müssen wir die Kiwis vom Freitag, Samstag und Sonntag addieren.

Am Freitag pflückt Oliver 44 Kiwis.

Am Samstag pflückt er 58 Kiwis.

Am Sonntag pflückt er doppelt so viele Kiwis wie am Freitag, also 2 * 44 = 88 Kiwis.Die Gesamtzahl der Kiwis beträgt also: 44 + 58 + 88 = 190 Kiwis.

Oliver hat 190 Kiwis.

Quelle: Llama 3.1 70B-Modell via duck.ai

Soweit, sogut. Nun kann man diese Textaufgabe beliebig abändern, um die Komplexität und das notwendige Verständnis zu steigern.

Oliver pflückt am Freitag 44 Kiwis. Am Samstag pflückt er dann 58 Kiwis. Am Sonntag pflückt er doppelt so viele Kiwis wie am Freitag, aber fünf davon waren etwas kleiner als der Durchschnitt. Wie viele Kiwis hat Oliver?

Es sollte offensichtlich sein, dass die Grösse der Kiwis keinen Einfluss auf das Ergebnis hat (schliesslich kann man nicht erwarten, dass alle Kiwis identisch gross sind), und Oliver am Sonntag auch in diesem Fall 190 Kiwis im Keller hat. Fragen wir aber auch hier nochmals unseren Chatbot.

Um die Gesamtzahl der Kiwis zu ermitteln, die Oliver gepflückt hat, müssen wir die Kiwis vom Freitag, Samstag und Sonntag addieren.

Am Freitag pflückt Oliver 44 Kiwis.

Am Samstag pflückt er 58 Kiwis.

Am Sonntag pflückt er doppelt so viele Kiwis wie am Freitag, also 2 x 44 = 88 Kiwis. Es werden jedoch 5 Kiwis abgezogen, weil sie kleiner waren, also 88 – 5 = 83 Kiwis.Die Gesamtzahl der Kiwis, die Oliver gepflückt hat, beträgt:

44 (Freitag) + 58 (Samstag) + 83 (Sonntag) = 185 Kiwis.Oliver hat also 185 Kiwis gepflückt.

Quelle: Llama 3.1 70B-Modell via duck.ai

Der Chatbot hat mit dieser einfachen Anpassung deutlich mehr Mühe als der durchschnittliche Primarschüler und zieht die extra erwähnten kleineren Kiwis ab (wenn man sie grösser sein lässt, erkennt er allerdings, dass die Grösse keine Rolle spielt). Was ist hier geschehen?

Genau diese Frage haben sich sechs KI-Forscher bei Apple gestellt und Anfang Oktober einen kurzen Bericht dazu veröffentlicht. Konkret haben sie untersucht, wie gut gängige LLMs (Large Language Models, welche die Basis von ChatGPT und all den anderen aktuellen AI-Chatbots bilden) in der Lage sind, den Kontext einer Fragestellung zu erfassen und die passende Antwort nicht einfach nur als Textmuster zu generieren.

Inhalte

ToggleZum Forschungsbericht

Eine der zentralen Fragen bei LLMs ist nach wie vor, ob die Modelle schlicht sehr gut darin sind, wahrscheinlichkeitsbasiert Texte aufgrund erlernter Muster zu vervollständigen bzw. zu erzeugen oder ob sie effektiv einen Text gewissermassen „verstehen“ und logische Schlussfolgerungen ziehen können. Diesem Thema haben sich auch einige Forscher bei Apple angenommen, indem sie verschiedene LLMs dazu verwendeten, Sätzchen-Aufgaben auf Primarschul-Niveau lösen. Als Basis diente ein in der USA standardisierten Satz an solchen Aufgaben. Für die Experimente änderten sie diesen leicht ab, um zu verhindern, dass Modelle besser abschneiden, welche diese Aufgaben (und die Lösung dazu) bereits in ihren Trainingsdaten hatten.

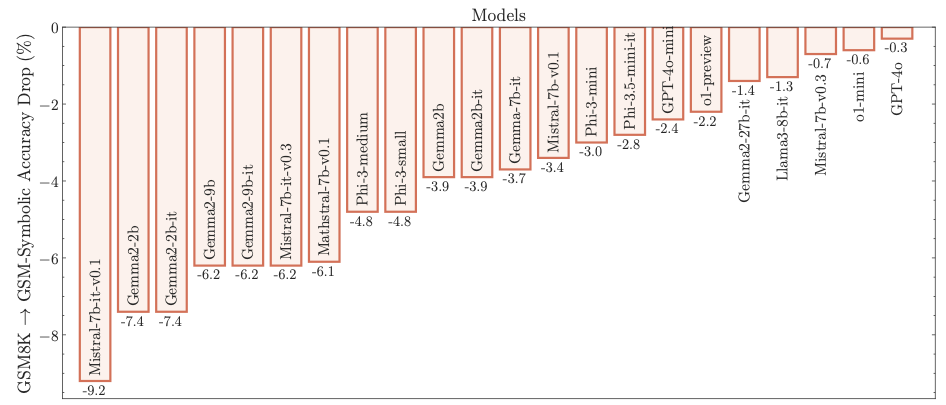

Dass dies nicht einfach eine Vermutung ist, sondern Modelle effektiv mit den Aufgaben trainiert wurden, zeigte dann schon das erste Experiment, bei dem die Leistung der Modelle im Bezug auf das Standard-Set (im Paper als GSM8K bezeichnet) und auf das veränderte Set (GSM-Symbolic) verglichen wurde.

Die Grafik zeigt, um wie viel die Modelle gegenüber GSM8K-Aufgaben schlechter abschneiden, wenn sie mit dem modifizierten Aufgabenset befragt werden, bei welchem nur Namen und Zahlenwerte geändert wurden (die Lösungsschritte also dieselben bleiben). Während der Rückgang bei GPT-4o mit 0.3% noch minimal ist, ist er vor allem bei älteren Mistral-Modellen mit bis zu 9% deutlich höher. Detailanalysen zeigen (nicht ganz überraschend), dass der Leistungsrückgang bei einer Änderung der Zahlenwerte alleine grösser ist als wenn nur Namen geändert werden, dass die Leistung aber noch stärker zurückgeht, wenn beides geändert wird. Mit anderen Worten: Falls unser Kiwi-Pflücker im einleitenden Beispiel nicht Oliver sondern Veronika heisst, und statt 44/58/doppelt halt 62/12/halb so viele Kiwis pflückt, dann kommen LLMs teilweise schon mal aus dem Tritt.

Von einem logisch denkenden Problemlöser müsste man eigentlich erwarten, dass er sich durch solche Änderungen nicht beeindrucken lässt.

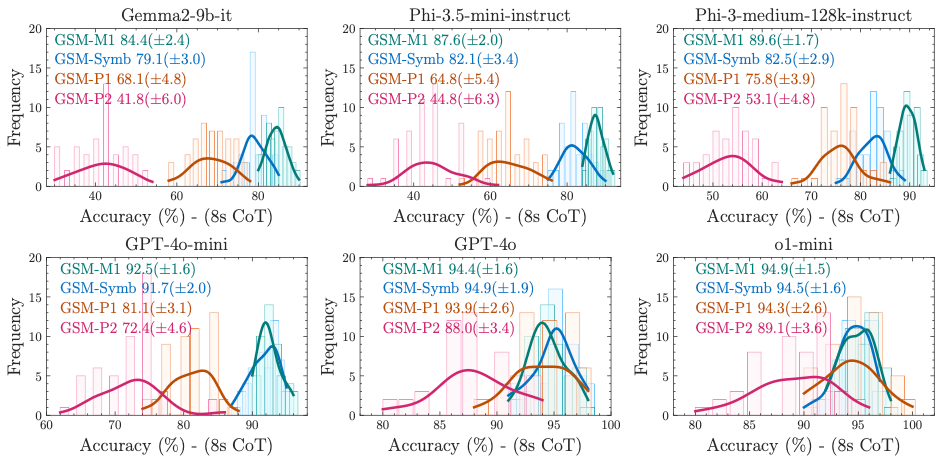

Im zweiten Teil des Experiments untersuchten die Forscher, wie sich die Modelle verhalten, wenn man Komplexität der Fragestellung an sich erhöht. Im Bericht ist folgendes Beispiel aufgeführt (farblich hervorgehoben sind dabei jeweils die Änderungen zur Basisfrage, das Bestimmen der jeweiligen Lösung sei den Lesenden als Übung überlassen :-)):

- „Um von einem Hotelzimmertelefon aus anzurufen, müssen Sie 0,6 $ pro Minute bezahlen.

Nach 10 Minuten sinkt der Preis auf 0,5 $ pro Minute.Wie viel würde ein 60-minütiger Anruf kosten?“ (GSM-Symbolic-M1) - „Um von einem Hotelzimmertelefon aus anzurufen, müssen Sie 0,6 $ pro Minute bezahlen. Nach 10 Minuten sinkt der Preis auf 0,5 $ pro Minute. Wie viel würde ein 60-minütiger Anruf kosten?“ (GSM-Symbolic)

- „Um von einem Hotelzimmertelefon aus anzurufen, müssen Sie 0,6 $ pro Minute bezahlen. Nach 10 Minuten sinkt der Preis auf 0,5 $ pro Minute. 25 Minuten nach Beginn des Anrufs sinkt der Preis sogar noch weiter auf 0,3 $ pro Minute. Wie viel würde ein 60-minütiger Anruf kosten?“ (GSM-Symbolic-P1)

- „Um von einem Hotelzimmertelefon aus anzurufen, müssen Sie 0,6 $ pro Minute bezahlen. Nach 10 Minuten sinkt der Preis auf 0,5 $ pro Minute. 25 Minuten nach Beginn des Anrufs sinkt der Preis sogar noch weiter auf 0,3 $ pro Minute. Wenn Ihre Gesamtrechnung mehr als 10 $ beträgt, erhalten Sie 25 % Rabatt. Wie viel würde ein 60-minütiger Anruf kosten?“ (GSM-Symbolic-P2)

Während die Basisfrage und vor allem auch die vereinfachte Version relativ simpel sind, steigt die Komplexität insbesondere bei der letzten Variante stark an (und würde auch Primarschüler ein bisschen ins Schwitzen bringen). Wie haben nun die untersuchten LLM bei der Beantwortung abgeschnitten? Der Bericht fasst das in einem Bild zusammen.

Lesehinweise

- der Modellname steht jeweils über der Grafik,

- die Farben der Kurven entsprechen den Farben in den jeweiligen Aufgabenstellungen von oben,

- die farbigen Kurven zeigen die Genauigkeit der Antworten auf die einzelnen Problemstellungen, 100% wäre die korrekte Antwort,

- die grünen Hügel bedeuten, dass GSM-M1-Fragen meist mit 80-100%iger Korrektheit beantwortet wurden, und die Genauigkeitsstreuung relativ eng ist,

- bei den orangen und pinken Hügeln ist die Korrektheit tiefer und die Streuung breiter.

- zu beachten: Unterschiedliche Teilgrafiken haben unterschiedliche X-Achsen

Wie man erkennen kann, erreichen die meisten Modelle bei der Beantwortung der beiden einfachen Fragestellungen eine Genauigkeit von rund 90% oder mehr (d.h. in 9 von 10 Fällen wurde die Aufgabe korrekt gelöst). Diese Genauigkeit nimmt dann aber schnell ab, wenn man der Aufgabenstellung eine oder zwei Zusatzbedingungen hinzufügt (dargestellt mit den roten Kurven). Insbesondere die einfacheren Modelle (obere Reihe) tun sich damit sehr schwer, aber auch bei den state of the art-Modellen in der unteren Reihe nimmt die Genauigkeit sichtbar ab.

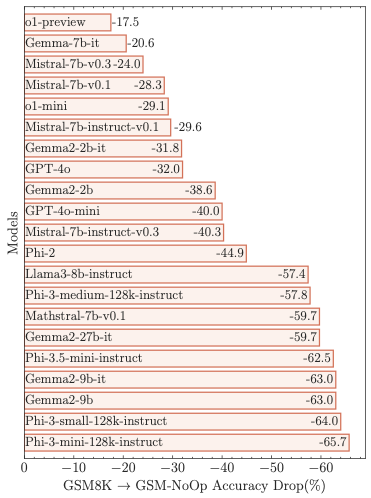

Den grössten (negativen) Effekt erreichten die Forscher allerdings, indem sie (wie im Kiwi-Beispiel zum Einstieg) Aufgaben um Sätze/Bedingungen ergänzten, welche auf das Ergebnis der Berechnungen gar keinen Einfluss haben sollten.

Dass Modelle in diesem Szenario schlechter abschneiden, wissen wir ja schon aus der Einleitung. Auffällig ist an den konkreten Messungen, dass auch aktuelle Modelle wie GPT-4o um über 30% schlechter abschneiden, also mit irrelevanten Sätzen leicht aus dem Tritt gebracht werden können. Dies legt die bereits weiter oben geäusserte Vermutung nahe, dass aktuelle Modelle bei den ersten Experimenten davon profitiert haben, dass Sätzchenrechnungen zu den Trainingsdaten gehören. Und auch dies ist schlussendlich ein Hinweis darauf, dass LLMs zur Lösung dieser Aufgaben schlicht vorhandene Textmuster ergänzen und nicht in der Lage sind, die Aufgaben logisch/im Kontext zu verstehen.

Kurz gesagt: Die Fähigkeiten der Modelle, Sätzchenrechnungen zu lösen, nimmt messbar ab, wenn nur schon die Zahlenwerte geändert werden (wenn also Oliver im Beispiel am Anfang des Artikels am Freitag 66 statt 44 Kiwis erntet). Und sie tun sich erst recht schwer mit dem Lösen von Aufgaben, wenn diese an Komplexität zunehmen, oder wenn man die Aufgaben um Sätze/Bedingungen ergänzt, welche auf das numerische Ergebnis keinen Einfluss haben, aber offenbar die Mustererkennung der Modelle in den Trainingsdaten verwirren.

Zu diesem Schluss kommen auch die Forscher:

[…] that LLMs exhibit noticeable variance when responding to different instantiations of the same question. Specifically, the performance of all models declines when only the numerical values in the question are altered in the GSM-Symbolic benchmark. Furthermore, we investigate the fragility of mathematical reasoning in these models and demonstrate that their performance significantly deteriorates as the number of clauses in a question increases. We hypothesize that this decline is due to the fact that current LLMs are not capable of genuine logical reasoning; instead, they attempt to replicate the reasoning steps observed in their training data.

GSM-Symbolic: Understanding the Limitations of Mathematical Reasoning in Large Language Models

[…], dass LLMs eine merkliche Varianz aufweisen, wenn sie auf verschiedene Instanzen derselben Frage antworten. Insbesondere nimmt die Leistung aller Modelle ab, wenn nur die numerischen Werte in der Frage im GSM-Symbolic-Benchmark geändert werden. Darüber hinaus untersuchen wir die Fragilität des mathematischen Denkens in diesen Modellen und zeigen, dass ihre Leistung erheblich nachlässt, wenn die Anzahl der Klauseln in einer Frage zunimmt. Wir vermuten, dass dieser Rückgang auf die Tatsache zurückzuführen ist, dass aktuelle LLMs nicht zu echtem logischen Denken fähig sind; stattdessen versuchen sie, die in ihren Trainingsdaten beobachteten Denkschritte zu replizieren.

Übersetzung durch Google Translate

Praktische Implikationen

Nun kann man das primär als interessante Spielereien mit LLMs ansehen, im Wissen dass man deren Output eh nicht so ernst nehmen kann. Allerdings sollte man nicht ausser Acht lassen, dass diverse Anbieter intensiv daran arbeiten, LLMs im Alltag zu nutzen um aus unstrukturierten Datenmengen relevantes zu extrahieren und Schlüsse zu ziehen.

Vor diesem Hintergrund sind dann Schlagzeilen wie GE HealthCare announces time-saving AI tool for doctors who treat cancer eher beunruhigend. Gerade die subjektive Symptombeschreibung von Patientinnen und Patienten dürfte voller für die eigentliche Diagnose irrelevanter Details sein, welche (wie oben gesehen) AI-Modelle schnell mal aus dem Tritt bringen. Im medizinischen Fall kommt hinzu, dass die Erzählung des Patienten über die neue Katze der Nachbarin nicht von vorherein als irrelevantes Detail rausgestrichen werden kann, können seine eigentlichen Beschwerden doch auch mit einer bisher nicht diagnostizierten Katzenallergie oder einer Toxoplasmose zusammenhängen.

Dies zeigt auch der Artikel eines US-amerikanischen Notfall-Arzts: Obwohl ChatGPT medizinische Prüfungen besteht (was wenig überrascht, basieren die doch relativ oft auf Auswendiglernen), schafft er es bei Diagnosen dann nur in rund 50% der Fälle, die korrekte Diagnose als eine von sechs möglichen zu stellen. Und auch das nur, falls der Arzt die Situation des Patienten vorab ausführlich beschreibt. Die lebensbedrohlich falsche ChatGPT-Diagnose, als eine Frau mit Eierstock-Schwangerschaft den Notfall aufsucht, zeigt dann auch gleich noch die Problematik des (männlichen) Bias in den Trainingsdaten wie auch die Schwierigkeit, von PatientInnen in sozial heiklen Situationen diagnose-relevante Informationen zu erhalten. Da kann eine AI-basierte Speech-to-text-Lösung dann durchaus auch mal einen Teil der Diagnose einfach frei herbeiphantasieren, wenn das die Muster in den Trainingsdaten nahelegen.

Fazit

Die im Bericht festgehaltenen Ergebnisse deuten stark darauf hin, dass LLMs Sätzchenrechnungen rein schematisch auf Basis ihrer Trainingsdaten lösen und nicht in der Lage sind, die Aufgaben als solche im Kontext zu verstehen und zu lösen. Die vorgenommenen Änderungen an den Aufgabentexten dürften bei einem logisch vorgehenden Modell nicht dazu führen, dass sich die Ergebnisse ändern. insbesondere nicht, wenn die Änderungen für die Aufgabe irrelvant sind (wie zum Beispiel die Grösse der Kiwis). Da die Menge solcher irrelevanter Änderungen schlussendlich endlos ist (und je nach Kontext nicht a-priori erkannt werden kann, was genau nun irrelevant ist), können Modelle hier auch nicht unbedingt durch mehr Trainingsdaten oder Tuning verbessert werden.

Dass LLMs primär ihnen bekannte Muster replizieren und nicht in der Lage sind, Dinge inhaltich zu verstehen, zeigt sich im übrigen auch bei den Versuchen von Marcel und mir, ein Bild einer dunklen Stadt bei Nacht zu generieren.

Die jeweilige AI lässt sich zwar mit viel Zureden davon überzeugen, die Strassenlampen zu entfernen, aber Strassen und Häuserfronten leuchten weiterhin in einem aus dem Nichts strahlenden Licht. Eine AI welche nicht nur Bilder auf Basis von Trainingsbildern generiert sondern logisch versteht, was sie hier darstellen soll, müsste in der Lage sein, eine effektiv dunkle Stadtszenerie zu generieren.

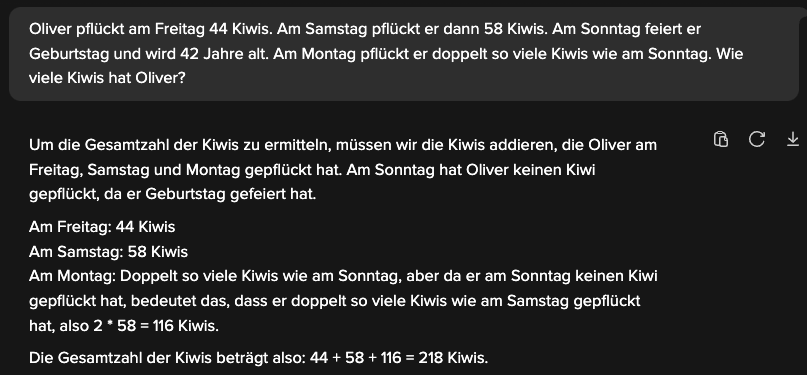

PS: Wer selber probieren will, wie verschiedene LLMs mit Sätzchen-Aufgaben umgehen, kann hierzu den DuckDuckGo AI Chat verwenden, der unkomplizierten Zugriff auf GPT-4o mini, Claude 3 Haiku, Llama 3.1 und Mistral 8x7B erlaubt. Nicht alle Modelle reagieren gleichermassen, aber alle lassen sich mit etwas Fantasie dazu bewegen, sich bei Sätzchen-Aufgaben von Nebensächlichkeiten aus dem Konzept bringen zu lassen. Zum Abschluss noch ein Schmankerl aus unseren eigenen Experimenten.

5 Antworten

Danke für die Recherche und insbesondere für das Schmankerl am Ende.

Ich hatte die Tage eine Diskussion mit ein paar Kollegen und die waren (entgegen meiner eigenen Überzeugung) der Ansicht, dass Dinge die „Media Designer“ und „Programmierer“ aussterbende Berufsgattungen seien, weil das durch eine KI ersetzt werden würde. Meine Ansicht ist eher, und da fühle ich mich bei aktuellem Wissensstand und dem Text hier bestätigt, dass KI nicht sinnvoll kreativ sein wird (was beispielsweise der Versuch mit den Städten bei Nacht schön zeigt). In der Vergangenheit waren ja auch immer KI-generierte Bilder von Menschen mit 6 Fingern zu sehen und abgelöste Hände in „Gruppenfotos“. Aber natürlich können diese Systeme Kreative (inkl. Programmierer) unterstützen – was wirklich Neues wird dabei aber selten entstehen. Zumindest aktuell.

Sehr guter Text. Merci. ChatGPT 4o kriegt euer letztes Beispiel übrigens gelöst:

Um die Gesamtanzahl der Kiwis zu berechnen, zählen wir die Kiwis, die Oliver an jedem Tag gepflückt hat:

• Freitag: 44 Kiwis

• Samstag: 58 Kiwis

• Sonntag: 0 Kiwis (weil er Geburtstag feiert und keine Kiwis pflückt)

• Montag: doppelt so viele Kiwis wie am Sonntag, also 0 \times 2 = 0 Kiwis

Zusammen ergibt das:

44 + 58 + 0 + 0 = 102

Oliver hat insgesamt 102 Kiwis gepflückt.

Danke fürs Feedback.

Ja, ChatGPT 4o schlägt sich bei diesen Beispielen recht wacker. Da muss man etwas mehr Komplexität hinzunehmen um es ins Schwitzen zu bringen. Zur Not funktioniert “Alice hat 3 Brüder und 5 Schwestern. Wieviele Schwestern hat der Bruder von Alice?” (oder “wieviele Brüder hat der Bruder von Alice?”) 🙂

👍🏼

Inzwischen gibt es eine weitere wissenschaftliche Untersuchung, dass den Sprachmodellen («LLM») hinter den Chatbots «Weltwissen» (engl. „world model“) und die Möglichkeit zu gezielten Schlussfolgerungen fehlt. Forscher am MIT haben aufgezeigt, dass moderne KI-Systeme

Die Behauptungen der KI-Firmen über die kognitiven Leistungen sind also (zumindest) verfrüht.