Hier eine subjektive Liste von dem, was mir beim Pendeln im Zug in der letzten Woche durch den Kopf ging.

Marcel pendelt schon länger. Und liest dabei Texte. Aber dies ist erst die zweite Instanz unserer Serie «Marcel pendelt». Mit zwei sehr unterschiedlichen Formaten. Sollen wir sie weiterziehen? Was gefällt euch daran, was sollten wir ändern? In den Kommentaren (und auf Social Media) hat es Platz.

Inhalte

ToggleFaule KI?

ChatGPT sei wie ein frischer Praktikant, heisst es: Man müsse deren Arbeit kontrollieren und korrigieren, da sie Umfeld und Kultur nicht kennten, heisst es. Andere vergleichen Chatbots mit einem faulen Mitarbeiter, der bei jeder Belehrung Ja und Amen sagt, aber dann trotzdem nichts daraus lerne.

Zu allem Überfluss scheint ChatGPT nun auch noch aufmüpfig zu werden: Seit einem Monat refüsiere es vermehrt stupide, repetitive Aufgaben, für die wir eigentlich dieses KI-Dings herangezüchtet haben. (Aussagen, dass GPT-4 fleissiger werde, wenn man ihm sage, es sei Mai, scheinen allerdings nicht reproduzierbar zu sein.)

Das eigentliche Problem ist, dass wir die Eigenschaften von Chatbots ganz schlecht testen können. In jedem Schritt werden Abermillionen Rechenoperationen ausgeführt, die niemand durchschaut. Und die auch niemand durchschauen kann. Weil die Idee ist ja, dass das System sich selbst die Muster extrahiert. Und was eine «KI» als „sinnvolles“ Muster ansieht, macht für Menschen meist keinen Sinn. (So werden Verkehrsschilder meist nicht an ihrer Form erkannt, um nur ein Beispiel zu nennen.)

Zudem ist es beweisbar unmöglich, diese grossen Systeme wirklich zu «verstehen». So können geheime Hintertüren in die Trainingsdaten so eingebaut werden, dass sie niemand finden kann, wenn er/sie nicht das Geheimnis kennt.

Und es kommt noch ganz viel Zufall dazu. Der ist wichtig, macht die Systeme aber extrem schwer zu reproduzieren. (Und führt nebenbei auch dazu, dass jede Antwort anders ist. Und dass die grossen Sprachmodelle (LLM, Large Language Model) wie ChatGPT nicht wirklich wissen, ob sie Wahrheit oder Bullshit „sagen“.)

Was lernen wir daraus?

Gute Software durchläuft im Normalfall eine Unzahl an rigorosen Tests, bevor sie auf uns User losgelassen wird. Und trotzdem schummeln sich Fehler durch diese Tests.

Bei LLM-Chatbots wie ChatGPT sind solche Tests kaum automatisierbar, da jedesmal etwas Anderes herauskommt. Und selbst wenn dasselbe Resultat ausgespuckt wird: Eine kleine Umformulierung der Frage kann zu einem überraschend anderen Ergebnis führen.

Diese Systeme sind kaum automatisiert testbar. Bisher nicht; möglicherweise gar nie. (Auch die Aktivitäten von Menschen sind nicht vorhersagbar. Auch wenn wir dort wenigstens zwischendurch Vertrauen in die Aktionen des Menschen haben.)

«KI ist nicht intelligent»

Wenn grosse Sprachmodelle mit 1000 Mal so viel Text (und mehr) gefüttert würden, wie ein Mensch vor dem 18. Lebensjahr konsumieren könne, müsse man sich nicht verwundern, wenn da ganz viel Textwissen da sei, meint Hector Martin. Der Turing-Test sei unter diesen Rahmenbedingungen kein Test für Intelligenz. Wer aus diesen oder anderen Resultaten glauben würde, dass diese Sprachmodelle intelligent seien oder auf dem Weg zur Artificial General Intelligence (AGI), sei auf dem Holzweg. Wir sollen ihm, Martin, doch bitte erst wieder mit solchen Nachrichten kommen, wenn ein KI-Modell eigenständige Schlussfolgerungen getätigt habe, ohne vorher mit dem gesammelten Wissen aus dem Internet gefüttert worden zu sein.

(Was nicht heissen soll, dass aktuelle Sprachmodelle und Chatbots nicht doch Anwendungen haben. Wir sollten sie einfach nicht für intelligent halten, zumindest nicht im menschlichen Sinne.)

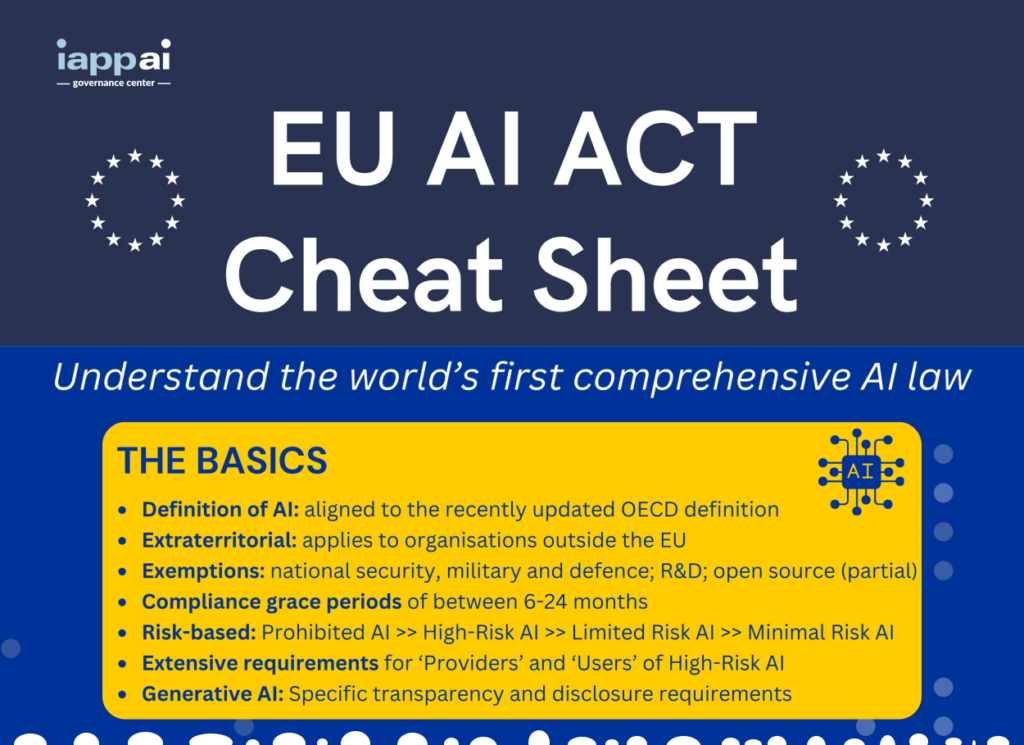

KI-Regulierung der EU

Vor einer guten Woche hat man sich in der EU auf die Stützpfeiler des «AI Act» zur KI-Regulierung geeinigt. Oliver Patel von der IAPP hat dazu eine (englische) Zusammenfassung erstellt.

Privatsphäre von Google-Bewegungsdaten

Vor einem Jahr hat Google die URL für ihren Kartendienst geändert. Ein unauffälliger Schritt, aber mit potenziell grossen Auswirkungen auf die Privatsphäre. Jetzt fügt der Suchmaschinenriese eine neue Funktion ein, die scheinbar die von Google-Produkten erfassten Bewegungsdaten besser schützt. Aber auch hier wahrscheinlich das Gegenteil bewirkt:

Let’s not fall for Google’s app-specific settings trick again: You don’t want the ability to delete location data „from Maps“; you want the ability to delete location data from „your entire account.“

Ron Amadeo im Ars-Technica-Artikel «Let’s attempt to decode Google’s confusing new location data settings»

[Update 2023-12-30] Die Befürchtungen im Ars-Technika-Artikel scheinen nur durch uneinheitliche Benennung seitens Google entstanden zu sein. Entsprechend aktualisierte Ron Amadeo seinen Artikel am 15. Dezember.

Privatsphäre bei Push-Nachrichten

Letzte Woche ging die Nachricht um die Welt, dass US-Geheimdienste Push-Nachrichten bei Apple und Google abschnorchelten. Beide Firmen betreiben für ihre jeweiligen Mobilbetriebssysteme (iOS und Android) Push-Server, über die zentral alle Echtzeit-Benachrichtigungen an die Nutzer und Mobil-Apps laufen müss(t)en: Wenn eine neue Mail ankommt, wenn in einem Online-Spiel eine wichtige Aktion passiert ist etc. Aber eben auch, wenn (und wann) euch jemand über euren Lieblings-Messenger eine neue Nachricht zukommen lässt.

Hier deshalb ein Überblick über einige der Dienste, welche Push-Nachrichten nutzen:

| Dienst | Funktionsweise |

|---|---|

| Alle Webanwendungen im Browser (Web Push) | Zwangsweise Ende-zu-Ende-verschlüsselt |

| Signal Threema iMessage ProtonMail (weitere…) | Wecken nur die App auf; diese holt sich dann die Nachricht über ihr normales (E2E-)Protokoll |

| Viele andere (z.B. Games) | Nur transportverschlüsselt (d.h. Netzwerkanbieter kann nicht mitlesen, aber der Betreiber des Push-Service) |

Aber auch bei Ende-zu-Ende-Verschlüsselung fallen (potenziell gefährliche) Metadaten an. Alleine schon die Tatsache, wann welche Push-Nachrichten für welche Nutzer und welche Anwendung anfallen, kann viel über die Person (und ihre Kommunikationspartner) verraten.

Threema betreibt deshalb einen eigenen Push-Server, den man unter Android auswählen kann und damit unabhängig ist von Google. Dies ist aber mit Arbeit verbunden (sowie einer etwas kürzeren Akkulaufzeit und auf vielen neueren Android-Versionen mit einer persistenten Nachricht auf dem Startbildschirm). Andere Diensteanbieter nutzen bzw. betreiben UnifiedPush-Server, der auf Android als Alternative zu Googles Push-Dienst eingesetzt werden kann.

Privatsphäre bei Facebook

Meta (Facebook, Instagram, WhatsApp, Threads, Metaverse, …; nicht „the original Meta company„) bietet seit Kurzem die Möglichkeit an, sich von Werbung freizukaufen. Ulrich Kelber, der oberste deutsche Datenschützer, der sich aktuell selbst vertreten muss (oder so), hat dazu im Fediverse einen Thread geschrieben:

Ulrich Kelber am 15. Dezember 2023 auf @bfdi@social.bund.de (Auszug)

- Grundsätzlich sind sogenannte „pur“-Abos als Alternative zum Tracking datenschutzrechtlich machbar. Die @dsk hat sich damit schon beschäftigt: https://www.datenschutzkonferenz-online.de/media/pm/DSK_Beschluss_Bewertung_von_Pur-Abo-Modellen_auf_Websites.pdf

- Was Meta nun anbietet ist Augenwischerei. Trotz „pur“-Abo werden weiter personenbezogene Daten erhoben und gespeichert. Sie sollen nur (vorgeblich) nicht mehr für personalisierte Werbung genutzt werden. Das alleine widerspricht schon dem Gedanken einer echten, datenschutzfreundlichen Alternative.

- In der Sekunde, in der das Abo erlischt, werden außerdem alle während des Abo-Zeitraums gesammelten Daten sofort wieder für personalisierte Werbung genutzt. Auch das enttarnt Metas „pur“-Abo als Scheinlösung.

- Meta hat seine Datenerhebung und -verarbeitung nicht vollständig unter Kontrolle. Leaks und Whistleblower zeigen das sehr eindeutig. Auch das lässt mich an einer datenschutzrechtlich einwandfreien technischen Lösung beim „pur“-Abo zweifeln.

Kelber zweifelt daran, dass sich Meta damit an die DSGVO halte und das mehr als nur eine öffentlichkeitswirksame Aktion sei. Er will sich zusammen mit den anderen EU-Datenschützern dafür einsetzen, dass sich auch Meta an die DSGVO halten müsse.

2 Antworten

Danke für diesen Wochenüberblick. Gefällt mir sehr gut! Fand auch den letzten (ersten) Beitrag gut, aber wenn ich wählen müsste, wäre es diese Art „Wochenrückblick eines Pendlers“.

Danke für das Lob! Ja, ich tendiere auch eher zu dieser Art des Wochenrückblicks. Freue mich aber auch gerne über mehr Feedback.