Vor einem knappen Jahrhundert hat sich Alan Turing mit den Fundamenten der heutigen Informatik beschäftigt: Kryptographie, Komplexität/Rechenaufwand, aber auch, ob und wie wir erkennen könnten, ob Computer „intelligent“ seien.

Dieses Imitationsspiel kennen wir heute als Turing-Test und ist aktuell wieder in aller Munde, weil gerade behauptet wird, dass Computer inzwischen intelligenter seien als Menschen, was am Montag bereits Thema hier war. Der Test ist aber auch interessant, weil sich Definition und Anwendung über die Jahre stark verändert haben. Er zeigt damit auch auf, wie sich unsere Beziehung zu Computern sowie natürlicher und künstlicher Intelligenz verändert hat.

Und gibt eine Chance, über uns und unsere Erwartungen an künftige Computer nachzudenken. Also los!

Inhalte

ToggleDie traditionelle Erzählung

The Imitation Game (Turing, 1950)

Turing stellte sich um 1950 herum die Frage, ob Maschinen denken könnten. Aber schon alleine über die Frage, was «denken» eigentlich bedeutet, wurde schon Jahrhunderte diskutiert. Als Ausweg erfand Turing daher einen Test, mit dem die Frage beantwortet werden könne, ohne dass man sich über philosophische Interpretation von «denken» einigen müsse:

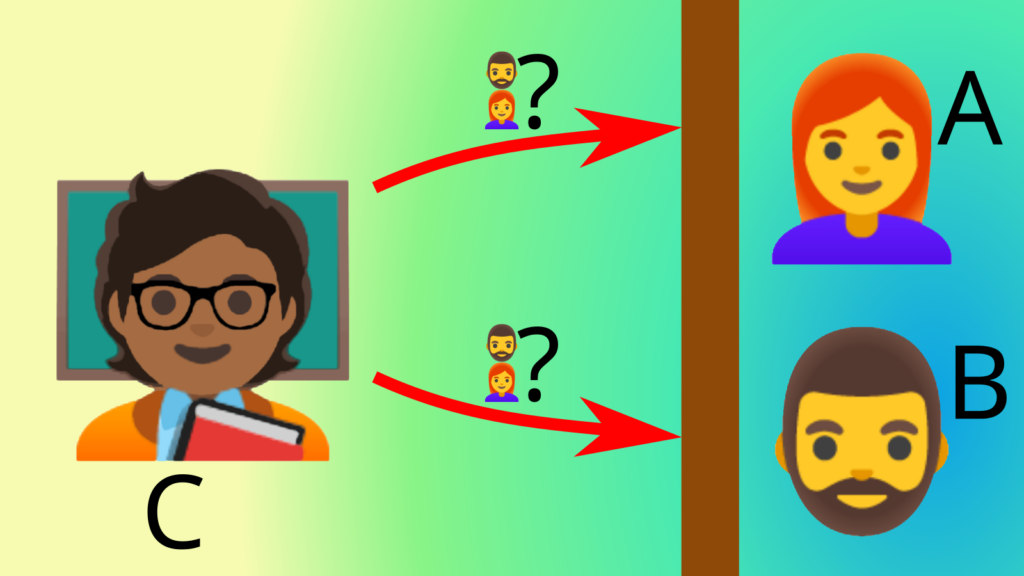

- Eine Fragestellerin kommuniziert schriftlich mit zwei Personen in einem anderen Raum, einem Mann (A) und einer Frau (B). Die Fragestellerin soll herausfinden, wer wer ist. Einer der beiden im Raum (A oder B) soll mit seinen Antworten versuchen, die Fragestellerin zu verwirren, während die andere ihr helfen soll. Das Resultat des Experiments ist, wie häufig die Personen richtig zugeordnet werden können.

- In einer zweiten Variante soll nun eine Person im Raum durch einen Computer ersetzt werden. Auch hier wird die Häufigkeit der korrekten Zuordnung gemessen.

- Ein Computer gilt dann als «denkend», wenn in beiden Experimenten du Zuordnungen ähnlich häufig korrekt sind.

Das Imitation Game von Alan Turing umfasste damit ursprünglich durch die Aufgabenstellung alle Aspekte und Details des menschlichen Verhaltens inklusive Werte, Geschlecht und Täuschung (Und über Täuschung, was einer der Kritikpunkte an dieser ursprünglichen Ausprägung des Tests ist.)

Dieser Test wurde aber zu Lebzeiten von Turing († 1954) nie durchgeführt, da ein Computer, der einen Menschen erfolgreich imitieren könne, damals noch ferne Zukunftsmusik war. Und heute wäre er in dieser Form wohl auch kaum mehr durchzuführen, da bei menschliche Probanden eigentlich immer im Vorfeld über die Ziele des Versuchs aufgeklärt werden müssen.

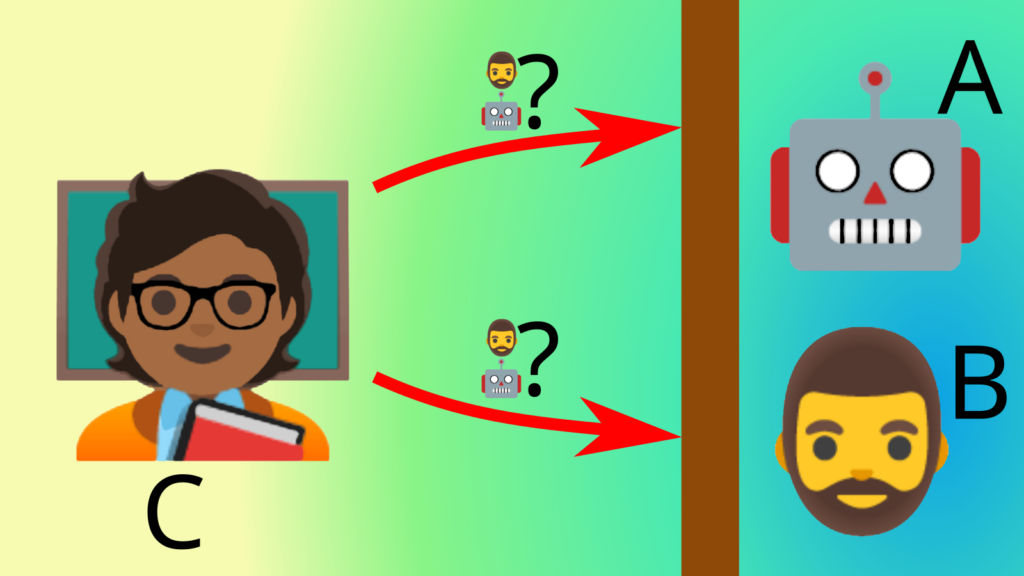

Die bekanntere, heutige Version

Weil das alles zu kompliziert war, wurde der Test vereinfacht. Der Proband kommuniziert über Tastatur und Bildschirm mit zwei Gesprächspartnern: Ein Mensch, eine Maschine. Wenn der Proband nach intensiver Befragung seiner Gegenüber nicht entscheiden kann, wer Mensch, wer Maschine ist, wird der Maschine ein dem Menschen ebenbürtiges (Denk-)Vermögen unterstellt.

Damit wird oft auch — teils implizit, teils explizit — ein Fokus auf den Intellekt impliziert.

Angeregte Entwicklungen

Auch auf Basis dieser Überlegungen Turings begannen Anstrengungen, Maschinen (bzw. Programme) zu erzeugen, welche den Menschen imitieren konnten. Die Idee der Künstlichen Intelligenz war geboren.

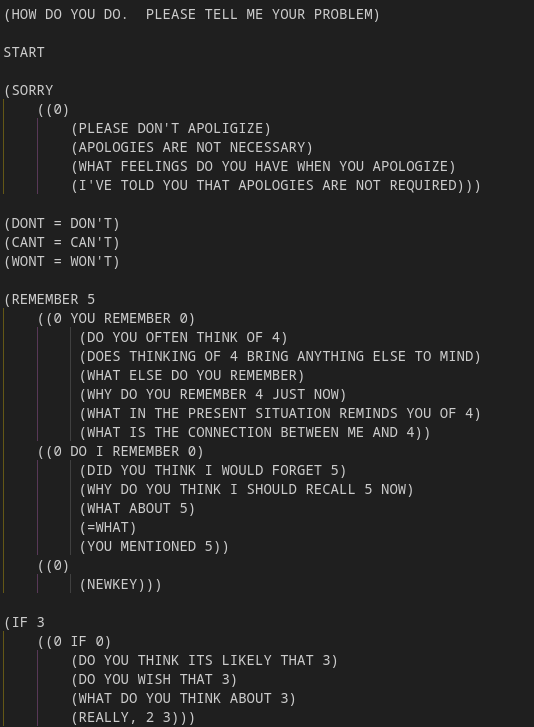

- Ein erster Meilenstein gelang Joseph Weizenbaum 1966 mit seinem Programm «Eliza», welches natürlichsprachige Interaktion erlaubte. Die Reaktion des Computers auf die menschlichen Eingaben war im Vergleich zu heutigen Text-KIs rudimentär: Hauptsächlich hat das Programm im menschlichen Satz nach Schlüsselwörtern gesucht und daraus geeignet scheinende Rückfragen erstellt. Trotz dieser Einfachheit des Programms kann man sich über einige Sätze hinweg mit dem „Gegenüber“ unterhalten, bis auffällt, dass die Gegenseite sehr eintönig (und manchmal einfältig) reagiert.

Eine grafisch sehr ansprechende, ansatzweise zeitgemässe, Simulation des Eliza-Feelings gibt es bei Masswerk zu erleben. Oder hier eine deutsche Variante (mit eingeschränktem Wortschatz). - Es war sehr aufwändig, die ganzen Regeln von Hand aufzustellen, nach denen diese Expertensysteme Antworten auf Fragen liefern sollten. Informatiker haben den Ruf, sich vor repetitiven Arbeiten zu drücken. Deshalb haben sie mutmasslich das Maschinelle Lernen erfunden, eine Technik, in der der Computer selbst die Regeln herausfinden soll.

- Daraus sind dann später die heutigen Large Language Models (LLM, grosse Sprachmodelle) entstanden wie z.B. ChatGPT, die auf selbst erarbeiteten Statistiken zu Wort-, Satz- und grösseren Mustern beruhen.

Aktuelle Erfolge

In verschiedenen Medien wurde vor einigen Wochen berichtet, dass ChatGPT den Turing-Test bestanden habe. Patrick Seemann hat einen Blick hinter die Kulissen geworfen. Seine Schlussfolgerungen:

- Es hat einen sehr umfangreichen Prompt mit 130 Zeilen Text gebraucht, um einen Rahmen für weitgehend belanglose Gespräche zu definieren.

- Mit etwas Aufwand lässt sich ChatGPT durch gezielte Fragen zumindest in die Enge treiben (auch wenn der Prompt dafür sorgt, dass der Bot nicht direkt zugibt, ein Bot zu sein), auch wenn das in den Selbstversuchen teilweise länger als die Experimentdauer gebraucht hat.

- 22% der Probanden haben selbst den sehr simplen Eliza-Chatbot als Menschen wahrgenommen, es scheint also einen nicht zu vernachlässigen Teil der Bevölkerung zu geben, welcher solchen Chats gegenüber relativ unkritisch ist oder im Alltag genau diese Art von Chats führt.

- Es ist unklar, inwieweit die Teilnehmenden motiviert waren, den Chat-Partner ernsthaft zu identifizieren bzw. wie ernst sie das ganze überhaupt genommen haben.

Eine weitere Frage ist, ob wir überhaupt zwischen Mensch und Computer als Gegenüber unterscheiden können müssen. Doch dazu später mehr.

Differenzierung Mensch–Maschine: Der andere Blickwinkel

Das Imitation Game von Alan Turing umfasste ursprünglich durch die Aufgabenstellung alle Aspekte und Details des menschlichen Verhaltens inklusive Werte, Geschlecht und Täuschung. Die einzige Einschränkung war, dass der Computer nur schriftliche Kommunikation beherrschen musste (was den Computer auch davon entband, sofort und unmittelbar reagieren zu müssen). Abgesehen davon sollte ein vollwertiger digitaler Klon eines Menschen entstehen; nur dieser konnte beim Test bestehen.

Eine Herkulesaufgabe. Schon recht bald wurden daher Test und Forschungsarbeit auf den Intellekt reduziert: KI-Forschung fokussierte auf Dinge wie Expertensysteme (z.B. Krankheit diagnostizieren) und Bilderkennung. Und es entstanden Light-Versionen des Turingtests, ob ein Mensch oder eine Maschine bei einer spezifischen Aufgabe besser sei. Dies Vereinfachung wurde auch dadurch erleichtert, dass die ursprüngliche Fragestellung in Turings Artikel lautete: «Can machines think?» («Können Maschinen denken?») und die Beispielfragen (mit Ausnahme einer Frage nach Haarlänge) kognitiver Natur waren:

Q: Please write me a sonnet on the subject of the Forth Bridge.

A: Count me out on this one. I never could write poetry.

Q: Add 34957 to 70764

A: (Pause about 30 seconds and then give as answer) 105621.

Q: Do you play chess?

A: Yes.

Q: I have K at my K1, and no other pieces. You have only K at K6 and R at R1. It is your move. What do you play?

A: (After a pause of 15 seconds) R-R8 mate.

Der theoretische Beispieldialog über Sonnette (abgelehnt), Addition (durchgeführt) und Schach (durchgeführt) aus Turings 1950er-Paper «Computing Machinery and Intelligence», in dem er das Imitation Game postulierte.

Der aktuelle Wechsel zurück auf menschliche Werte und die Untiefen der Seele ist deshalb ein wichtiger Schritt. Wir sind wieder beim ursprünglichen holistischen Bild von Turing 1950 angekommen. Oder wie die Angelsachsen sagen würden: «It has come full circle.»

Schauen wir uns deshalb an, welche Kriterien für die Unterscheidung von KI vs. Mensch nacheinander im Fokus standen:

Kriterium 1: Intelligenz

Der altbekannte Ansatz war: «Der Computer soll uns beweisen, dass er intelligent ist!»

Aber dann kamen Schachcomputer und Watson, der 2011 beim Wissensquiz Jeopardy gewann. Der menschliche Intellekt war zwiegespalten: Auf der einen Seite sind Computer jetzt besser als wir. Auf der anderen Seite sind wir aber die Schöpfer dieser unglaublichen „Geschöpfe“!

Gleichzeitig begannen Computer «zurückzuschlagen», uns Menschen auf die Probe zu stellen: Seither müssen wir beweisen, dass wir keine Computer sind, indem wir auf absichtlich verrauschte Bilder klicken.

Nicht nur hat uns der Computer geschlagen, „er“ begann im Gegenzug, uns Arbeit aufzuhalsen. Das hat also schon einmal gar nicht funktioniert.

Kriterium 2: Kreativität

Die nächste Hoffnung war: «Kreativität ist etwas zutiefst Menschliches, ein Computer kann das nicht!»

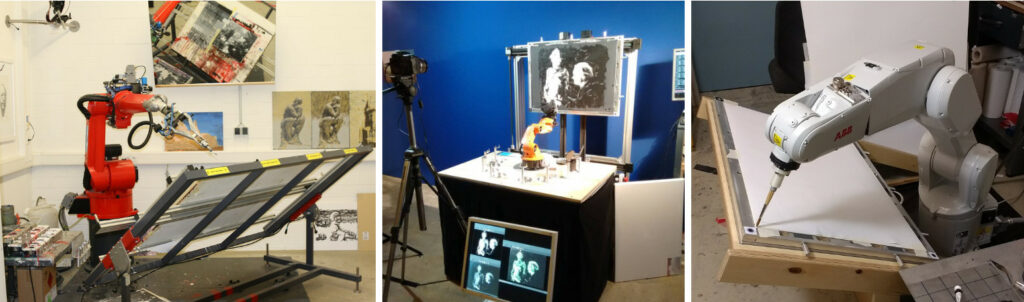

Auch hier begann es rasch zu bröckeln, als malende Roboter auftauchten. Und ChatGPT erste Gedichte ausspuckte oder DALL-E Phantasiewelten in Bilder zu giessen begann.

Aber war das «Kreativität»? Was ist überhaupt Kreativität? Und könnte ein typischer Mensch solche Kreativität aus dem Stegreif liefern? Fragen über Fragen, aber wenig Antworten, die uns bei der Unterscheidung von Mensch und Maschine helfen könnten.

Kriterium 3: Mitgefühl

Also war eine bessere Idee gefragt: «Der Computer soll uns beweisen, dass er Mitgefühl hat!» (oder zumindest dieses Mitgefühl überzeugend simulieren).

Aber dann kamen LLMs wie ChatGPT, grosse Sprachmodelle, die beliebig Sätze und Satzmuster aus allen menschlichen Äusserungen kombinieren konnten. Einige dieser generierten Muster („Antworten“) waren liebevoll, einige hilfreich, einige völlig falsch oder am Thema vorbei. Wieder andere aber auch hässlich, grausam, beleidigend, drohend.

Die Firmen hinter den KIs wollten sich aber nicht blamieren (oder verklagen lassen) und haben entsprechend ihre KIs gezähmt.

Kriterium 4: Ungezähmt

Deshalb kam die nächste Idee auf: «Dann soll uns der Computer doch einmal beweisen, dass er böse oder lüstern sein kann!»

An der Weigerung, ungezügelten Text zu produzieren, kann man immer noch viele kommerzielle Chatbots erkennen. Aber es gibt inzwischen auch unzählige Chatbots, die genau dafür „gezüchtet“ wurden, frech oder lüstern zu agieren. Eine Herstellerin von KI-Ersatzfreundinnen wurde sogar öffentlich dafür gerügt, als diese KI-„Freundinnen“ irgendwann weniger sexuell expliziten Dialog ermöglichten (und musste den Chatbot auf Druck der User kurze Zeit später wieder in der „bewährten“ Erotikstufe verfügbar machen).

Also ist auch dieses Kriterium inzwischen wieder Geschichte. Auch wenn es gegen viele seriöse Chatbots weiterhin funktioniert.

Kriterium 5: Äh, ja, was nun?

Eine einfache Lösung scheint es nicht zu geben, wie wir bei einem Gegenüber zwischen Mensch und KI unterscheiden können. Hier ein paar Fragen, die wir uns stellen sollten:

- Ist es mir wichtig, das Gegenüber zu identifizieren? Wieso? (Aufbau einer gegenseitigen Beziehung, Einschätzung der Vertrauenswürdigkeit, …)

- Reicht es mir, wenn ich weiss, was das Gegenüber leisten kann? Was zuverlässig, was weniger zuverlässig, was gar nicht?

- Will ich echte Empathie? Reicht mir auch eine überzeugend Vorgetäuschte (Empathie vortäuschen können auch Menschen)?

- Will ich eine echte menschliche Leistung dahinter?

- Will ich echte X (was auch immer mein X ist)? Oder reicht mir eine Annäherung daran?

- Wenn ich das Gegenüber bezahle (mit Geld oder Daten): Will ich, dass ich weiss, wohin diese Bezahlung fliesst?

- Wenn ich Böses vermeiden will: Hilft es mir zu wissen, ob das Gegenüber Mensch oder Maschine ist?

Schlussfolgerungen

Menschen haben ein Recht darauf, menschenwürdig behandelt zu werden. Im Privatleben, im Verkehr mit Firmen, aber auch gegenüber staatlichen Stellen sollte diese menschenwürdige Behandlung eigentlich selbstverständlich sein. Wer sie nicht bekommt, sollte reklamieren; egal, ob diese «unmenschliche» Behandlung durch einen Menschen oder eine KI geschieht.

Alle Personen, welche privat, in Organisationen oder in der Öffentlichen Hand darüber entscheiden, wie Interaktionen mit Menschen stattfinden, haben die Aufgabe, dafür zu sorgen, dass sich diese Menschen menschlich behandelt vorkommen. Gerade auch in Fällen, wo das Gegenüber oder sein Problem besonders ist.

KI-Systeme werden heute für eine wachsenden Zahl an Aufgaben eingesetzt. Meist durch Personen, welche bewusst und freiwillig die Unterstützung von solchen KIs als Werkzeugen in Anspruch nehmen. Oft durch solche, im Umgang mit diesen Werkzeugen geschult sind und wissen, wo man sie sinnvoll einsetzt und wo nicht oder sogar wissen, wo ihr Einsatz gefährlich ist. Und welche in der Lage sind, die Resultate dieser Systeme zu beurteilen und Sinn von Unsinn zu trennen.

Das ist aber einfacher gesagt als getan: Denn Menschen haben erwiesenermassen einen Automation Bias, d.h. wir trauen Entscheiden von Computern oft auch dann, wenn dieser falsch liegt. (Hinzu kommen immer komplexere Prozesse, welche die Menschen gar nicht mehr sinnvoll überschauen können, Arbeitsüberlastung bei den menschlichen Kontrolleuren, zu kurze Reaktionszeiten für einen Entscheid oder dass durch die zusätzliche Abstraktionsebene Fehlentscheidungen öfter in Kauf genommen werden.)

In Fällen, wo dies (a) nicht gegeben ist, wo (b) Menschen keine Wahl haben oder (c) gar nicht wissen, wer ihr Gegenüber ist, sollten aktuelle KI-Systeme nicht eingesetzt werden.

Denn es will sich niemand unfair oder kafkaesk behandelt vorkommen, egal ob durch Menschen oder Maschinen.

Weiterführende Literatur

Turing-Test und Menschlichkeit

- Patrick Seemann: ChatGPT besteht den Turing-Test, gilt KI jetzt als intelligent?, DNIP, 2024-07-15.

Was das «bestehen des Turing-Tests» durch KI bedeutet. Ein Blick hinter die Kulissen. - Zoe Stavri aka Another Angry Woman: If you are human, answer me this, 2023-11-05.

Motivation für die Liste mit der Entwicklung der Tests (Teile des Threads sind NSFW) - UNO: Die Allgemeine Erklärung der Menschenrechte, 1948.

Einige grundsätzliche Überlegungen zur Menschenwürde. Immer wieder lesenswert.

Künstliche Intelligenz verstehen

- Marcel Waldvogel: Machine Learning: Künstliche Faultier-Intelligenz, DNIP, 2022-08-16.

Maschinelles Lernen, eine Vorstufe der aktuellen Chatbots, am Beispiel von Bilderkennung einfach erklärt. - Marcel Waldvogel: Wie funktioniert eigentlich ChatGPT?, DNIP, 2023-01-30.

Die modernen Chatbots sind aus vielen einfachen Statistik-Schritten clever kombiniert.

Fehlentscheidungen rund um KI

- Adrienne Fichter: «Drohnen verringern die politischen Kosten eines Krieges», Republik, 2021-12-08.

Menschen, welche KI-Entscheidungen zu verifizieren haben, auch über Leben und Tod, haben manchmal gar nicht genügend Zeit und/oder Informationen, um überhaupt einen sinnvollen Entscheid zu tätigen. - Patrick Seemann: KI & Kindsmissbrauch — Wenn gut gemeint das Gegenteil von gut ist, DNIP, 2022-08-28.

Das Ziel von KI-Einsatz ist oft die Reduktion der Anzahl Personen. Die wenigen Verbleibenden müssen dann im Akkord KI-Entscheidungen verifizieren. - Automation bias, Wikipedia, lebendes Dokument.

Wieso Menschen fälschlicherweise der Ausgabe eines Computersystems nicht richtig hinterfragen. - Algorithmwatch Schweiz und 42 weitere Organisationen: Künstliche Intelligenz mit Verantwortung … ohne Diskriminierung, 2024.

Appell an den Bundesrat, dass KI-Systeme in der Schweiz verantwortungsvoll eingesetzt werden und diskriminierungsfrei sein soll. (Wer will, darf ihn gerne unterzeichnen. Ich z.B. habe das.)