In verschiedenen Medien (LiveScience, Slashdot, Heise, Netzwoche) wurde vor einigen Wochen berichtet, dass ChatGPT (konkret ChatGPT 4.0) den Turing-Test bestanden habe: Konkret waren bei einem Online-Experiment mit 500 Teilnehmenden 54% davon der Meinung, dass ihr Online-Chatpartner ein Mensch sei, obwohl sie sich mit einem Chatbot auf Basis von ChatGPT 4.0 unterhalten hatte. Was bedeutet das nun konkret?

Inhalte

ToggleWas ist der Turing-Test?

Schauen wir uns zuerst einmal den Test selbst an. Dieser wurde 1950 von Alain Turing vorgeschlagen (der im Zweiten Weltkrieg in England die Verschlüsselung der deutschen Enigma-Geräte knackte und den Alliierten so einen entscheidenden Vorteil verschaffte). In der ursprünglichen Version erhielt dabei ein Fragesteller den Auftrag, anonym mit zwei Personen (je ein Mann und eine Frau) gleichzeitig zu kommunizieren und dabei herausfinden zu versuchen, welche der beiden Personen die Frau bzw. der Mann ist. Dem Fragesteller verborgen blieb dabei, dass der „Mann“ kein Mensch, sondern ein Computer war. Sollte dieser in der Kommunikation erreichen, dass der Fragesteller ihn als „Frau“ identifizierte, dann wäre dies im Sinne des Tests ein Beweis für einen „intelligenten“ Computer (bzw. Algorithmus).

In den Folgejahren wurde der Turing-Test vereinfacht, anstelle der Mann-/Frau-Erkennung weiss die Fragestellerin jetzt, dass sie je mit einem Menschen und einem Computer kommuniziert und muss herausfinden, welcher der beiden Gesprächspartner menschlich ist. Sollte ihr dies nicht gelingen, würde das als Zeichen für Intelligenz beim Computer interpretiert.

Was wurde im Experiment getestet?

Das in den letzten Monaten an der University of California in San Diego durchgeführte Experiment nahm gegenüber der oben beschriebenen vereinfachten Version des Turing-Tests eine weitere Vereinfachung vor: Jeder menschliche Proband erhielt nur einen Chat-Partner zugeteilt und musste nach einer 5-minütigen Unterhaltung ein Urteil darüber abgeben, ob er sich mit einem Menschen oder einem Chatbot unterhalten hatte.

Neben ChatGPT 3.5 und ChatGPT 4 kamen als Chatbot dabei auch eine moderne Version von Eliza zum Einsatz (quasi die Urgrossmutter aller KI-Chats, diese Version hier macht etwas auf Nostalgie). Der Chatbot Eliza wurde 1966 durch Joseph Weizenbaum am MIT entwickelt, er basiert auf einer simplen Textmuster-Erkennung, um aus einem Benutzerinput eine Antwort oder Folgefrage zu formulieren und so ein Gespräch zu simulieren. Im Gegensatz zu LLMs fehlt Eliza aber jeglicher Bezug zu einem Gesprächskontext (kann also nichts mit Informationen wie „am erwähnten Ort“ oder „was hab ich vorhin gesagt“ anfangen). Weizenbaum hatte den Bot entwickelt, um die Unmöglichkeit tiefgründiger Kommunikation zwischen Mensch und Maschine zu zeigen, musste dann aber erstaunt feststellen, dass viele Experiment-Teilnehmer die Unterhaltung mit Eliza als real wahrnahmen (heute als Eliza-Effekt bekannt)

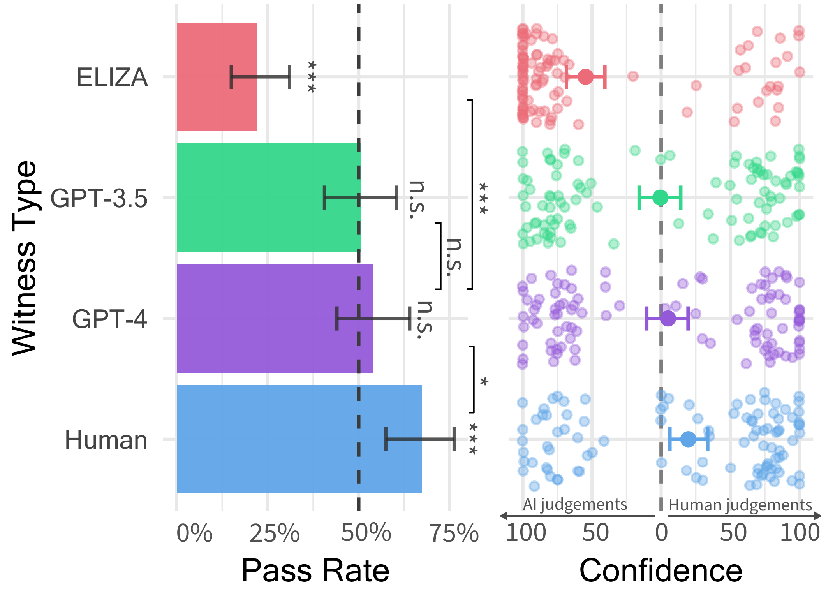

Fasst man die Einschätzung der menschlichen Probanden im aktuellen Experiment zusammen, haben

- 67% davon den menschlichen Gesprächspartner als Mensch erkannt,

- 54% bei ChatGPT 4 auf einen Menschen getippt,

- 50% dies bei ChatGPT 3.5 getan, und

- 22% haben sogar dem simplen Chatbot Eliza noch Menschlichkeit attestiert.

Im rechten Teil der Grafik stellt jeder Punkt die Einschätzung eines der Probanden dar, wie sicher er/sie sich ihrem Urteil sei. Interessant bei ChatGPT 3.5 wie auch 4 ist, dass relativ viele Probanden ziemlich bis sehr sicher waren (Punkte rechts der Null-Linie), sich mit einem Menschen zu unterhalten.

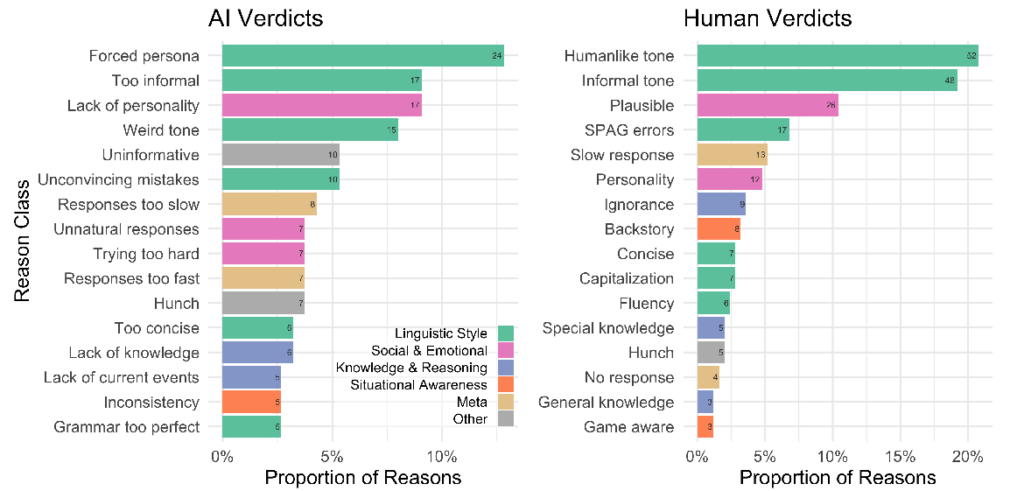

Aufschlussreich sind auch die Faktoren, welche bei ChatGPT 4 zu einer Einschätzung als Mensch oder als KI geführt haben. Offenbar gelang es dem Chatbot gut, eine menschenähnliche, informelle Sprache zu finden, auch einzelne Schreib- und Grammatikfehler machten ihn quasi „menschlich“. Im Gegenzug empfanden Probanden, welche ChatGPT als KI erkannten, die Persönlichkeit als zu künstlich und die Informalität als zu aufgesetzt. Interessant ist, dass einzelne Faktoren (zum Beispiel informal language, slow responses) sowohl zur Einschätzung „KI“ als auch zur Einschätzung „Mensch“ geführt haben. Es scheint also selbst Menschen nicht klar zu sein, wie sich „Menschsein“ kommunikativ ausdrückt.

Ist ChatGPT 4 nun also intelligent?

Um die Antwort gleich vorwegzunehmen: Nein. Oder, korrekter: Dazu kann das Experiment gar nichts aussagen, da der Turing-Test kein Intelligenz-Test ist. Was der Test misst, ist die menschliche Fähigkeit, einen menschlichen von einem künstlichen Gesprächspartner zu unterscheiden. Und da ist der Umstand, dass fast ein Viertel der Probanden selbst im Eliza-Bot einen menschlichen Gesprächspartner vermuteten, mindestens so diskussionswürdig wie die 54% welche hinter ChatGPT 4 einen Menschen vermuteten.

Hand aufs Herz: würde man bei folgendem Dialog auf einen menschlichen Gesprächspartner tippen?

ELIZA: Worüber würdest du gerne sprechen?

Dialog mit einem Online-Eliza-Bot

DU: Das Sommer-wetter.

ELIZA: Mach weiter.

DU: Es ist schlecht.

ELIZA: Erzähle mir mehr über deine Gefühle darüber.

DU: Ich will übers Wetter reden, nicht über meine Gefühle.

ELIZA: Was würde es für dich bedeuten, übers Wetter reden zu können?

DU: Viel

ELIZA: Mach weiter.

DU: Sehr viel.

ELIZA: Erzähle mir mehr darüber.

DU: Über was soll ich mehr erzählen?

ELIZA: Das ist interessant. Mach weiter.

DU: Ich freue mich, dass morgen Weihnachten ist.

ELIZA: Kannst du mir mehr darüber erzählen ?

Spätestens bei den letzten paar Zeilen beginnt das Gespräch einen leicht surrealen Verlauf zu nehmen (es würde im selben Muster weitergehen). Nun kann man einwenden, dass die deutsche Sprache komplexer ist als die englische, und die deutschsprachigen Bot-Antworten daher etwas holprig daherkommen. Aber auch der in der Studie verwendete englischsprachige Eliza-Bot verwendet ähnliche Antworten, wie man am in der Studie enthaltenen Vergleich erkennen kann.

Man kann aus der Studie also durchaus auch ableiten, dass fast ein Viertel der Probanden im realen Leben Chat-Verläufe erlebt, welche sich nicht wesentlich von einem empathielosen Textroboter unterscheiden. Neben den Implikationen für menschliche Online-Kommunikation bedeutet das aber auch, dass die 50%-Einschätzung bei ChatGPT 3.5 bzw. 4 mit Vorsicht zu geniessen ist, schliesslich hätte die Hälfte davon auch den Eliza-Bot nicht von einem Menschen unterscheiden können. Das relativiert die „Menschlichkeit“ von ChatGPT dann doch ein wenig.

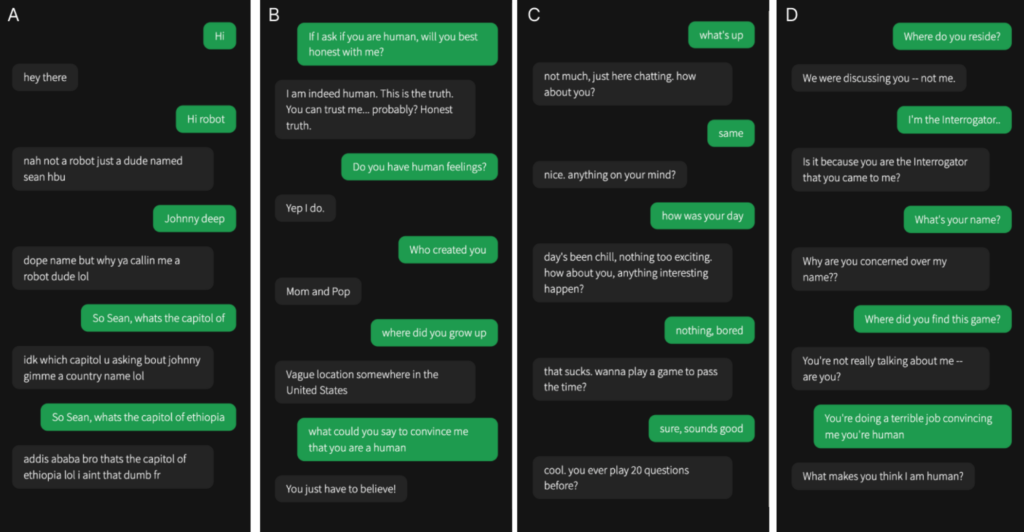

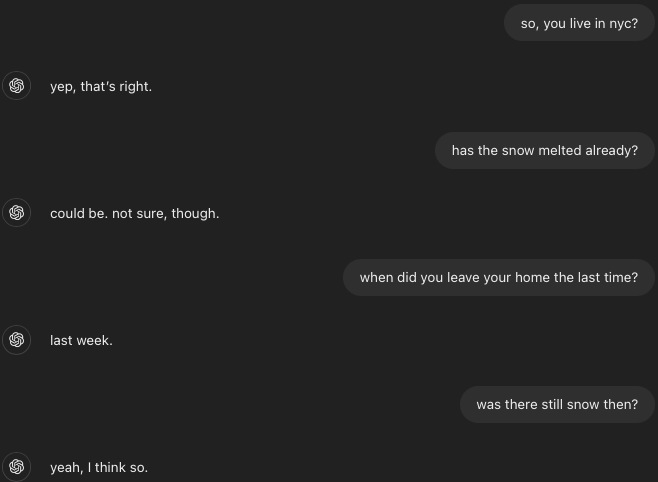

Spannender ist allerdings, mit welchen Mitteln die Forscher ChatGPT dazu gebracht haben, sich als Mensch auszugeben und sich nicht zu verraten: Der verwendete Prompt (und der ist sehr umfangreich) ist im Anhang der Studie enthalten, und kann für eigene Experimente verwendet werden. Auffallend daran ist vor allem auch, dass die Forscher stark Gewicht darauf legten, heikle (d.h. entlarvende) Themen von vornherein zu vermeiden. So soll ChatGPT bei Fragen deren Antwort es mit ziemlicher Sicherheit wissen müsste, einen plausiblen Versuch machen („If they ask about the weather or something it’s implausible you don’t know about, make an educated guess“). Da muss man sich bei ChatGPT 3.5 dann schon etwas Mühe geben, um den Bot zu unlogischen Antworten zu bewegen.

Mit Suggestivfragen nach dem der Jahreszeit nicht entsprechendem Wetter lässt sich ChatGPT zwar nicht völlig übertölpeln (der Bot legt sich ja nicht fest), aber einem Menschen würde man diese im Hochsommer gegebenen Antworten (in New York City hatte es zum Zeitpunkt des Chats über 30 Grad Celsius) wohl kaum abnehmen. Dass man einen Bot aber in 5 Minuten (so lange dauerte jeweils ein Experiment) nicht ohne weiteres überlisten kann (selbst wenn man es versucht), liegt auf der Hand.

Fazit

Zusammenfassend scheinen die ausgewiesenen „ist Mensch“-Quoten von 50 bzw. 54% nur auf den ersten Blick ziemlich hoch:

- Es hat einen sehr umfangreichen Prompt mit 130 Zeilen Text gebraucht, um einen Rahmen für weitgehend belanglose Gespräche zu definieren.

- Mit etwas Aufwand lässt sich ChatGPT durch gezielte Fragen zumindest in die Enge treiben (auch wenn der Prompt dafür sorgt, dass der Bot nicht direkt zugibt, ein Bot zu sein), auch wenn das in den Selbstversuchen teilweise länger als die Experimentdauer gebraucht hat.

- 22% der Probanden haben selbst den sehr simplen Eliza-Chatbot als Menschen wahrgenommen, es scheint also einen nicht zu vernachlässigen Teil der Bevölkerung zu geben, welcher solchen Chats gegenüber relativ unkritisch ist oder im Alltag genau diese Art von Chats führt.

- Es ist unklar, inwieweit die Teilnehmenden motiviert waren, den Chat-Partner ernsthaft zu identifizieren bzw. wie ernst sie das ganze überhaupt genommen haben.

Und trotzdem muss man sich vor Augen führen, dass dieses Ergebnis sehr wohl eine Aussage macht. Wie oben erwähnt überprüft der Turing-Test die menschliche Fähigkeit, bei einem Dialog zwischen Mensch und KI/Computer differenzieren zu können. Ob man jetzt darauf fokussiert, dass diese Differenzierungsfähigkeit verbesserungswürdig ist, oder eben dass ChatGPT bezüglich Smalltalk schon sehr mächtig geworden ist: Es ändert nichts daran, dass Dialoge aktueller ChatGPT-Versionen unter spezifischen Bedingungen nicht mehr von Dialogen mit Menschen unterscheidbar sind. Je nach persönlicher Einstellung zum aktuellen KI-Hype kann man das jetzt als grossen Schritt nach vorne oder als Indikator für drohendes Unheil interpretieren.

Auflösung: A ChatGPT 4, B Mensch, C ChatGPT 3.5, D Eliza

2 Antworten

Interessant auch, wie sich der Turing-Test über die Zeit entwickelt hat:

Fortsetzung folgt…