UPDATE (1. Juli 2021) ZU DIESEM ARTIKEL WEITER UNTEN

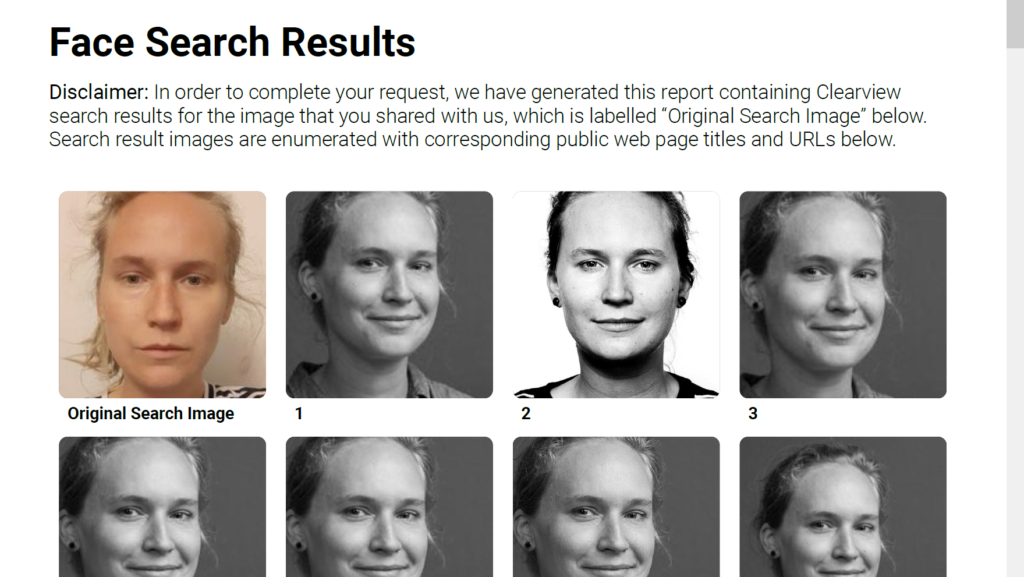

Nach dem ernüchternden Ergebnis bei Spotify und Netflix wollte ich nun wissen, welche biometrische Daten die umstrittene Gesichtserkennungsapp Clearview.AI über mich speichert. Ich war relativ sicher, dass ich in dessen Datenbank schlummere, denn Bildmaterial im Netz existiert ja zu Genüge. Und so hab ich diverse Abfragen gestartet und wollte wissen wie weit ich dabei gehen kann: ich frage nach einer Datenauskunft für mich, für eine EPFL-Professorin und für einen Schweizer Bundesrat.

In zwei Fällen war ich erfolgreich, in einem Fall nicht. Dies legt den Verdacht nahe: Clearview.AI reichert- entgegen ihrer offiziellen Policy- die Bilder mit persönlichen Daten an und entscheidet bei Datenauskünften fallweise.

Doch der Reihe nach: Zu Beginn 2020 – noch vor dem Ausbruch der Pandemie in Europa- sorgte die NYT-Enthüllung für einigen Wirbel weltweit. Polizistinnen halten ihr Smartphone auf einen Verdächtigen mitten auf der Strasse, die App weist die Identität der Person in Sekundenschnelle aus. Fundort: das Internet. Ihre Datenbank: mehrere Milliarden Bilder.

Dabei bediente sich das Unternehmen Clearview.AI öffentlich verfügbarem Material von FB, LinkedIn etc. Gesichtserkennungstechnologien sind relativ ausgereift und frei verfügbar, vor allem für die Auswertung von „statischem“ 2D-Material im Netz. So hat SRF herausgefunden, welche Politikerinnen auf Instagram-Postings auftauchten. Ob der Live-Test auch auf der Strasse funktioniert? Gemäss den Informationen von Clearview.AI natürlich schon, einige Strafverfolgungsbehörden sagen was anderes dazu.

Doch gehen wir nochmals einen Schritt zurück und bleiben wir bei der virtuellen Welt. Ich ging davon aus, dass ich mit grosser Wahrscheinlichkeit einen festen Eintrag bei der Clearview-Datenbank habe. Es gibt genügend Bildmaterial über mich, sei es von Auftritten, Profilbildern oder aus Artikeln.

Die Frage ist also: Findet mich Clearview.AI auf Anhieb, nachdem ich ihnen mein Selfie- ein Mugshot quasi- schickte?

Die Antwort: Natürlich ja. Und zwar 32 Mal.

Ich erhielt nach knapp 7-9 Tagen ein PDF mit meinen Bildern, wovon viele Male dasselbe Bild (etwa mein Republik-Profilbild) aufgelistet ist. Unterhalb den Bilder gibt es die verlinkten Quellen dazu.

Dabei stammt kein einziges Foto von Twitter, dafür LinkedIn und Flickr (interessanterweise auch nichts von Facebook, was wohl mit meinen Einstellungen zusammenhängen mag).

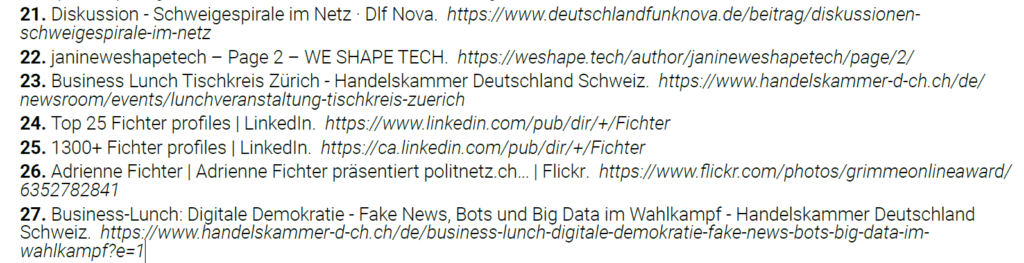

Zwei Treffer (unten Nummer 26 und Nummer 23 sowie 27) haben mich erstaunt. Weil: zum einen bin ich darauf wesentlich jünger. Der Treffer stammt aus dem Jahr 2011 (!), damals war ich in Düsseldorf bei der Fachtagung des Grimme Online-Awards und hielt einen Vortrag über mein Startup Politnetz.ch. Und bei den anderen Treffern ist mein Gesicht seitlich gerichtet. Auch das scheint offenbar keine Hürde mehr zu sein heutzutage für die Gesichtserkennung.

Es gibt viele gute Erklärtexte, wie genau die Vermessungen und Erkennung von statten geht: Von Kaspersky oder How stuff works, auch sei der Vortrag von Andreas Geppert (Winterkongress) empfohlen. Es werden Distanzen zwischen den Augen, von Auge zum Kinn etc vermessen, etc. in eine Zahlenreihe übersetzt und abgeglichen.

Auffällig ist: von mir existieren noch natürlich noch viel mehr und aktuellere Bilder. Hier muss es wohl bei der Erhebung etwa um das Jahr 2018 herum einen Schnitt gegeben haben.

Die Treffsicherheit bei Clearview.AI war also gegeben, bei allen gespeicherten Bildern handelt es sich um mich. Allerdings fragte ich mich: die Privacy-Zuständigen von Clearview wissen meinen Vor- und Nachnamen. Sie hätten also leicht eine Google Image Suche starten können mit meinem Vorlage-Selfie und diese mit meinem Vornamen und Nachnamen kombinieren können.

Clearview.AI behauptet jedenfalls von sich dies nicht zu tun. Gemäss eigenen Angaben sollen sie keine zugehörigen Namen, Emailadressen, Locations und weitere persönliche Informationen über uns erheben. Sie nummerieren oder verschlagworten die gescrapten Bilder also nach einer eigenen Logik.

We do not collect information about anyone’s name, email address, home address, location or any other type of information beyond photos and the links where they appear. We do not combine photos with other sorts of data to link them to a particular person—we only use our search technology to find images that are similar to one another, and the locations they appear online.

https://staticfiles.clearview.ai/clearview_data_policy.html

Um diese Aussage zu überprüfen, machten wir einen Test mit einem Fake-Account.

In Absprache mit der EPFL-Professorin und Privacy-Expertin Carmela Troncoso starteten wir eine Anfrage (mit einem Pseudonym-Account) und übermittelten ebenfalls ein Selfie von ihr. Zurück kam ein Datenfile mit 22 Treffern, bei allen handelte es sich um Carmela Troncoso. Teilweise waren auch Ausschnitte von Youtube-Videos drin enthalten, wie sie selbst bestätigte (als ich ihr die Datei vorlegte).

Wer übrigens selber eine Datenauskunft haben möchte: Selfie/Mugshot von sich selbst – frontal- machen und via Mail an privacy@clearview-ai.zendesk.com schicken.

Mit anderen Worten: Jeder kann für jeden eine Abfrage starten und die hinterlegten biometrischen Daten einer x-beliebigen Person bei Clearview.AI verlangen. Theoretisch.

Praktisch muss die Firma offenbar noch einige Sicherheitsvorkehrungen eingebaut haben oder einen VIP-Flag anwenden.

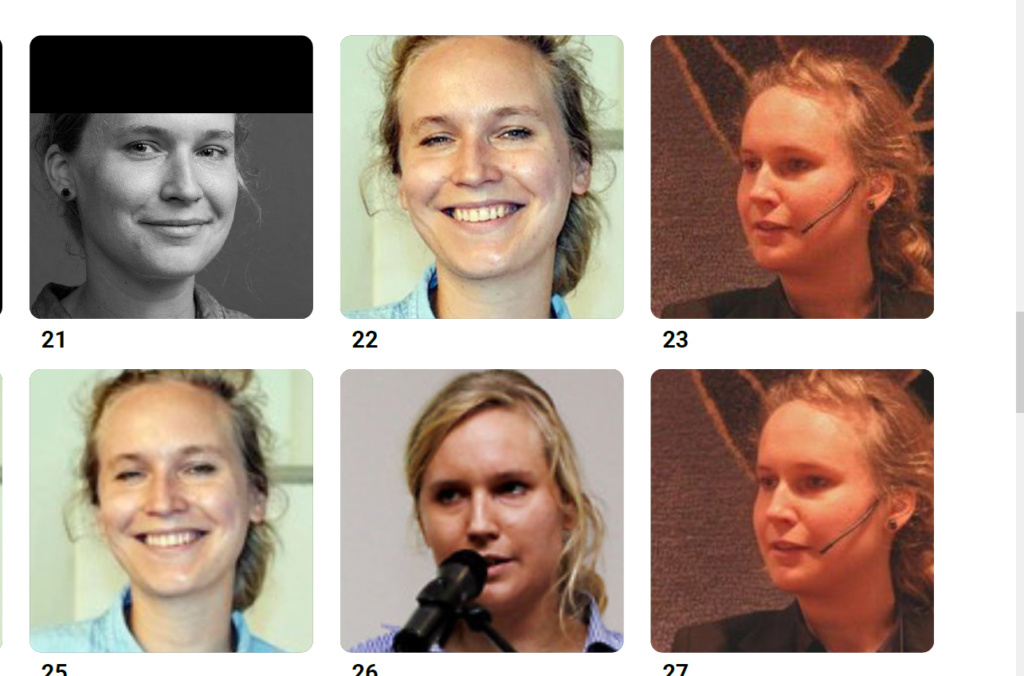

Denn bestärkt durch den „Erfolg“ bei Datenauskunft für Carmela Troncoso wagten wir uns an die nächste Stufe: Die Gesichtsdaten des SP-Bundesrats Alain Berset. Auch hierfür reichten wir ein Bild des Bundesrats ein.

Doch dann endete der Kommunikationsfluss mit Clearview.AI.

Trotz mehrmaligem Nachfragen haben wir bis dato kein „Gesichtsportfolio“ des Bundesrats erhalten. Irgendwo muss also Intervention – eine Art Alert- stattgefunden haben. Oder sie kamen uns auf die Spur, dass wir dies im Rahmen einer Recherche durchführen. Aber das ist alles nur Spekulation.

Doch es nährt einen weiteren Verdacht: Anders als Clearview.AI behauptet, ist es also durchaus denkbar, dass das Unternehmen unsere Gesichtsbilder katalogisiert, speichert und mit persönlichen Daten versieht. Denn weshalb sonst werden mir die Ergebnisse bei einem Schweizer Bundesrat verweigert, nachdem dies bei anderen Datensubjekten – Troncoso und mir- ja so zackig und ohne Nachfragen verlief?

Wir werden auf jeden Fall dazu weiter recherchieren.

Nach der Auskunft nahm ich mich der nächsten Herausforderung an: die Löschung meiner gespeicherten Gesichts-Daten. Das Perfide dabei: Plötzlich will Clearview meine Identität sehr genau wissen. Die Löschung funktioniert nur mit einem Passbild und der Information zur ausstellenden Behörde, was weder rechtlich noch logisch Sinn macht. Schliesslich verlangten sie diese Vorlage ja nicht für die vorherige Datenauskunft.

„If you are requesting data blocking or data opt out, please provide a government issued photo ID as well.

We encourage you to redact any personal information that you feel necessary from the latter. We only need to see your face and the issuing government.„

Aus der Antwortemail von Clearview.AI

Und hier wähne ich mich in meinem Dilemma. Möchte ich einem höchst dubiosen amerikanischen Unternehmen wirklich meine offiziellen Passdaten übermitteln und darauf vertrauen, dass sie diese im Anschluss löschen? Damit hadere ich. Ich lasse es vorerst bleiben.

Ohnehin scheint dass mit der Löschung eine Farce zu sein.

Spiegel-Redakteur Patrick Beuth unternahm bereits einen Versuch dazu – er reichte ein Löschungsbegehren ein- und erhielt von Clearview.AI lediglich eine Bestätigung, dass seine Daten ENTFERNT aus den Suchergebnissen und anonymisiert worden seien. Man beachte das Wording („entfernt“ und „anonymisiert“). Mit anderen Worten: einmal in der Clearview.AI-Datenbank (unfreiwillig) drin, kommt man nicht so leicht wieder raus.

Der eidgenössische Datenschutzbeauftragte Adrian Lobsiger reichte ein Löschungsgesuch für alle Schweizer:innen bei Clearview.AI stellvertretend ein. Gemäss des EDÖB-Tätigkeitsberichts des Jahres 2020 blieb dieses jedoch unbeantwortet.

„Reclaim your Face“ – wie es eine aktuelle europaweite NGO-Kampagne fordert- wird schwierig umzusetzen sein, bei solch absurden Schikanen für Löschungsbegehren. Das polnische Unternehmen Pimeye verlangt sogar Geld für die Wiedererlangung der Privatsphäre. Man vergegenwärtige sich das mal: Unfreiwillig abgegraste und gespeicherte Fotos löschen lassen NUR gegen Entgelt.

Bei der europäischen Zivilgesellschaft klingen zu Recht die Alarmglocken: Eine Bündnis von Bürgerrechtsorganisationen hat bei europäischen Datenschutzbehörden in Frankreich, Österreich, Italien, Griechenland und dem Vereinigten Königreich Klage gegen Clearview.AI eingereicht. Und: Der baden-württembergische Landesdatenschutzbeauftragte Stefan Brink geht gegen die mittlerweile auf den Seychellen ansässige Gesichtserkennungsfirma PimEyes vor.

Wir sind – wie es Kollege Beuth formuliert – biometrisches Freiwild. Gescrapt wird täglich, ohne Schranken und Kontrolle, dank des öffentlichen Charakters von Social Media und weiteren Plattformen. Die EU will nur den Umgang mit Live-Gesichtserkennung im öffentlichen Raum regulieren, jedoch keine Schranken für den digitalen Raum – ausser der DSGVO- explizit durchsetzen.

Hier noch ein Tipp vom Spiegel-Kollegen: Mit dem Tool LowKey der Universität von Maryland kann man diese Scraping-Saugpraktiken austricksen, indem man seine Gesichtsdaten leicht verfälscht. (durch sogenannte adversarial attacks). Mit „leicht“ ist folgendes gemeint: immer noch erkennbar genug für andere Menschenaugen, doch für die neuronalen Netze – also dem Gesichtserkennungssystem- verschieden genug, dass das gefakte Bild zu sehr vom Original abweicht und nicht korrekt zuordnet.

Ich werde also mal damit beginnen, meine Profilbilder mit diesen Artefakten auszutauschen.

UPDATE 1.7.2021: Es dauerte ein wenig länger, aber am Schluss erhielten wir doch die Bilder des SP-Bundesrats Alain Berset. Das Bildmaterial ist zwar reichhaltig, aber ziemlich homogen. Es handelt sich um 187 Fotos, davon mehrheitlich Medienartikel zu Presseauftritten von Berset zur Corona-Krise. Interessanterweise befanden sich darunter kaum Social Media-Quellen. Ist die These des VIP-Alerts also widerlegt?

Nun: da jede Person sich die Bilder von Alain Berset bestellen kann, wird somit keine Identität des Fragestellers und der Fragestellerin überprüft. Es ist also ein Fakt: jeder und jede kann bei Clearview eine Datenauskunft für eine x-beliebige Person einfordern. Wir haben dies unter einem Pseudonym für Alain Berset getan und waren dabei erfolgreich. Dass wir PDFs/biometrische Daten von fremden Personen erhielten, ist eine klare Verletzung von Datenschutz- und Datensicherheitsprinzipien gemäss DSGVO, argumentiert IT-Jurist Michael Veale. Wir hätten diese Daten niemals erhalten dürfen, erklärt er auf Anfrage von DNIP. Veale ist spezialisiert auf digitale Rechte und Regulierung.

„GDPR access rights give you a right to your own personal data alone. If an organisation includes personal data of others, they need to check they have a legal right to do so. For biometric data, that is extremely unlikely. If they hand it over regardless, that’s an illegal data breach. A company like ClearView is either ignoring or misinterpreting the law, or claiming it has a right to process biometric data, perhaps on the very questionable basis of ‘substantial public interest’ to fight crime. It certainly doesn’t have a legal basis to process biometric data to identify random people to supplying individuals or companies with that data for unspecified purposes.“

Michael Veale

Interessant ist aber: Das PDF, das wir erhielten, enthielt den Titel „Compliance Search“ und eine Aneinanderreihung von Zahlen, die nach einer konkreten ID-Nummer klang (ob damit die Suchnummer gemeint ist oder etwa die Profil-ID von Berset wissen wir nicht). Diese Titel fehlten in den Gesichtsportfolio-PDFs von Carmela Troncoso und mir. Ob mit Compliance eine Art „legal compliance/check“ oder Vorsichtsmassnahme gemeint ist, wissen wir auch nicht.

Wir können daher die These der Speicherung von persönlichen Daten pro Gesicht und Person weder ausschliessen noch bestätigen.

Eine Antwort

Danke für den Hinweis auf das Tool „LowKey“. Gibt es auch eine Lösung, bei der man die Bilder lokal bearbeiten kann und nicht in die USA schicken muss? Sieht mir ein wenig wie ein Honeypot aus 😉

Vielen Dank!